prompt

现在要实现一个服务的流量检测和动态限流模块,需要以下子模块:

- 请求接受层 LB:负载均衡接受请求流量

- 请求拦截层:安全策略,拦截恶意请求

- 请求限流层:可靠性策略,根据系统负载,限流不用业务的超流量请求,将请求进行降级

- 请求降级层:结合配置化的降级策略,处理请求,按照边界场景正常返回,不影响功能的使用和系统稳定性。

- 请求消费层:接入业务服务,按照业务流程正常梳理请求。

你是一个服务端开发工程师,请结合整体模块设计,使用责任链模式输出请求限流层子模块设计的方案。

answer

请求限流层子模块设计方案(责任链模式)

1. 设计目标

请求限流层需基于多维度限流策略(如业务线、用户、IP、系统资源),通过责任链模式实现灵活、可扩展的流量控制,确保系统在高负载时优先保障核心业务稳定性,同时支持动态调整限流阈值以适应实时负载变化。

2. 责任链模式核心设计

责任链模式通过处理器链对请求逐层处理,每个处理器(限流策略)决定是否拦截请求或传递至下一级。核心角色包括:

抽象处理器(RateLimitHandler):定义处理接口和链式调用方法。

具体处理器(ConcreteHandler):实现具体限流策略(如全局QPS限流、业务线限流、动态资源限流)。

上下文(RateLimitContext):封装请求元数据(如业务标识、用户ID、IP、时间戳)及限流结果。

3. 核心模块设计

3.1 抽象处理器(RateLimitHandler)

定义统一处理接口,规范链式调用逻辑:

public abstract class RateLimitHandler {

// 下一个处理器

protected RateLimitHandler next;

// 设置下一个处理器

public RateLimitHandler setNext(RateLimitHandler next) {

this.next = next;

return next; // 支持链式调用

}

/**

* 处理限流请求

* @param context 限流上下文(包含请求元数据)

* @return 限流结果(是否允许通过)

*/

public abstract RateLimitResult handle(RateLimitContext context);

/**

* 传递至下一个处理器

*/

protected RateLimitResult passToNext(RateLimitContext context) {

if (next == null) {

return RateLimitResult.allow(); // 链路末端默认放行

}

return next.handle(context);

}

}

3.2 具体处理器实现

根据限流策略实现不同处理器,示例包括:

3.2.1 全局限流处理器(GlobalQpsRateLimitHandler)

限制全局总QPS,防止系统整体过载:

public class GlobalQpsRateLimitHandler extends RateLimitHandler {

// 全局限流阈值(动态可调)

private volatile int globalQpsThreshold = 10000;

// 滑动窗口统计组件(记录最近1秒请求量)

private SlidingWindowCounter globalCounter = new SlidingWindowCounter(1000, 100); // 窗口大小1s,分100个桶

@Override

public RateLimitResult handle(RateLimitContext context) {

// 统计当前秒请求量

long currentQps = globalCounter.incrementAndGet();

if (currentQps > globalQpsThreshold) {

return RateLimitResult.block("全局流量超限");

}

return passToNext(context); // 未超限,传递至下一级

}

// 动态调整阈值(支持配置中心回调)

public void updateGlobalThreshold(int newThreshold) {

this.globalQpsThreshold = newThreshold;

}

}

3.2.2 业务线限流处理器(BusinessLineRateLimitHandler)

按业务线(如order_service、user_service)独立限流,保障核心业务:

public class BusinessLineRateLimitHandler extends RateLimitHandler {

// 业务线限流阈值(动态可调,如从配置中心获取)

private Map<String, Integer> businessQpsThresholds = new ConcurrentHashMap<>();

// 业务线滑动窗口统计(键:业务标识)

private Map<String, SlidingWindowCounter> businessCounters = new ConcurrentHashMap<>();

@Override

public RateLimitResult handle(RateLimitContext context) {

String businessLine = context.getBusinessLine();

// 获取业务线阈值(默认1000)

int threshold = businessQpsThresholds.getOrDefault(businessLine, 1000);

// 获取或初始化该业务线的计数器

SlidingWindowCounter counter = businessCounters.computeIfAbsent(businessLine,

k -> new SlidingWindowCounter(1000, 100));

long currentQps = counter.incrementAndGet();

if (currentQps > threshold) {

return RateLimitResult.block("业务线[" + businessLine + "]流量超限");

}

return passToNext(context);

}

// 动态更新业务线阈值(如配置变更时触发)

public void updateBusinessThreshold(String businessLine, int newThreshold) {

businessQpsThresholds.put(businessLine, newThreshold);

}

}

3.2.3 动态资源限流处理器(DynamicResourceRateLimitHandler)

基于系统实时资源(CPU、内存、线程池负载)动态调整限流阈值,弹性保护系统:

public class DynamicResourceRateLimitHandler extends RateLimitHandler {

// 资源监控客户端(获取CPU、内存等指标)

private SystemMonitorClient monitorClient;

// 基础限流阈值(资源充足时的默认值)

private int baseThreshold = 10000;

public DynamicResourceRateLimitHandler(SystemMonitorClient monitorClient) {

this.monitorClient = monitorClient;

}

@Override

public RateLimitResult handle(RateLimitContext context) {

// 获取当前系统负载(如CPU使用率)

double cpuUsage = monitorClient.getCpuUsage();

// 根据负载动态计算限流阈值(示例:CPU>80%时限流50%)

int dynamicThreshold = cpuUsage > 0.8 ? baseThreshold / 2 : baseThreshold;

// 统计当前请求量(使用全局或业务线计数器,此处简化为全局)

long currentRequests = GlobalCounter.get();

if (currentRequests > dynamicThreshold) {

return RateLimitResult.block("系统资源紧张,流量超限");

}

return passToNext(context);

}

}

3.3 限流上下文(RateLimitContext)

封装请求元数据,供处理器链使用:

public class RateLimitContext {

private String requestId; // 请求唯一ID

private String businessLine; // 业务线标识(如"order")

private String userId; // 用户ID

private String clientIp; // 客户端IP

private long timestamp; // 请求时间戳(ms)

// 其他扩展字段...

// Getter & Setter...

}

3.4 限流结果(RateLimitResult)

封装限流决策结果:

public class RateLimitResult {

private boolean allowed; // 是否允许通过

private String code; // 响应码(如"429")

private String message; // 提示信息

// 静态工厂方法

public static RateLimitResult allow() {

return new RateLimitResult(true, "200", "允许通过");

}

public static RateLimitResult block(String message) {

return new RateLimitResult(false, "429", message);

}

// 构造方法、Getter...

}

4. 责任链组装与初始化

通过配置或注解动态组装处理器链,支持灵活扩展:

public class RateLimitChainInitializer {

public static RateLimitHandler buildChain() {

// 初始化各处理器

GlobalQpsRateLimitHandler globalHandler = new GlobalQpsRateLimitHandler();

BusinessLineRateLimitHandler businessHandler = new BusinessLineRateLimitHandler();

DynamicResourceRateLimitHandler dynamicHandler = new DynamicResourceRateLimitHandler(new SystemMonitorClient());

// 组装责任链(顺序可配置,如先全局→业务线→动态资源)

globalHandler.setNext(businessHandler);

businessHandler.setNext(dynamicHandler);

return globalHandler;

}

}

5. 动态调整与监控

阈值动态更新:通过配置中心(如Apollo、Nacos)监听阈值变更事件,调用处理器的updateXXXThreshold方法实时调整。

监控指标上报:每个处理器统计限流次数、请求通过率等指标,上报至Prometheus/Grafana,用于可视化监控。

熔断降级联动:当某业务线频繁限流时,触发降级层执行备用逻辑(如返回缓存数据),避免级联故障。

6. 性能优化

无锁统计:使用ConcurrentHashMap存储业务线计数器,SlidingWindowCounter采用原子操作(如AtomicLongArray)实现滑动窗口,避免锁竞争。

轻量级判断:处理器链中优先执行低成本检查(如全局QPS),再执行高成本检查(如动态资源计算),减少无效计算。

异步统计:将请求计数操作异步化(如通过Disruptor环形缓冲区),降低对主线程的影响。

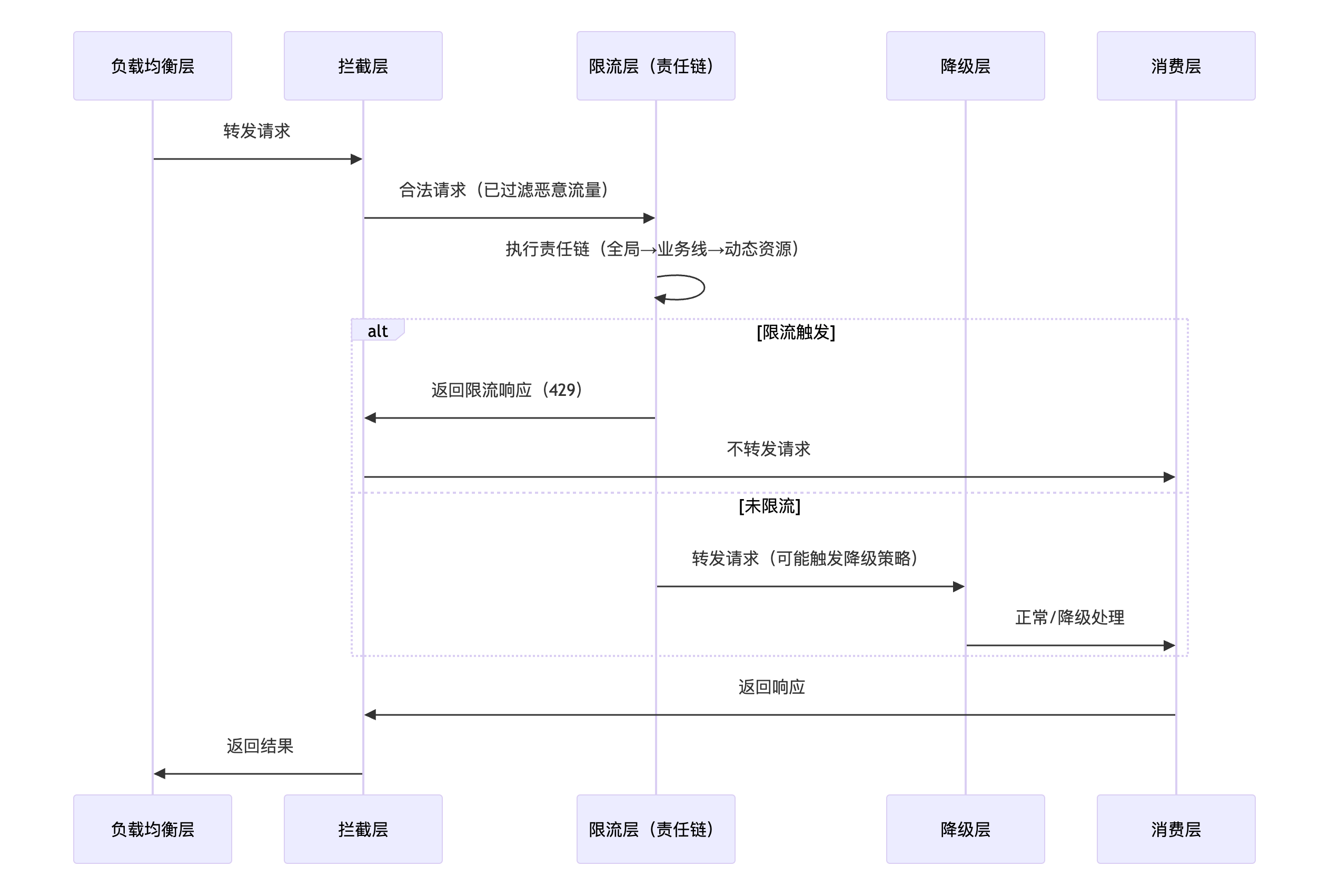

7. 集成流程

请求流量经LB→拦截层后,进入限流层处理:

8. 总结

本方案通过责任链模式实现了多维度、可扩展、动态调整的限流能力,核心优势如下:

灵活性:新增限流策略(如用户级限流)只需新增处理器并插入链中。

动态性:支持通过配置中心实时调整阈值,适应系统负载变化。

可观测性:完善的监控指标便于问题排查和容量规划。

高性能:无锁统计和异步处理确保低延迟,不影响主业务流程。

answer AI评估

请求限流层方案评估(责任链模式)

该方案基于责任链模式设计了多维度、可扩展的限流层,整体思路清晰且贴合实际需求。

以下从核心优势、潜在不足及改进方向三个维度展开评估。

一、核心优势

1. 模式适配性强,解耦效果显著

责任链模式的核心优势是将“多维度限流逻辑”拆解为独立的处理器(如全局、业务线、动态资源限流),每个处理器仅关注自身策略,符合单一职责原则。链式调用机制避免了传统条件判断(如if-else)的代码冗余,降低了模块间耦合度,新增限流策略(如用户级、地域级限流)时只需新增处理器并插入链中,扩展性极佳。

2. 多维度限流覆盖,保障系统稳定性

方案覆盖了全局流量控制(防止系统整体过载)、业务线独立限流(保障核心业务优先级)、动态资源限流(基于CPU/内存等实时指标弹性调整)三大核心场景,兼顾了“全局兜底”与“局部精细”的限流需求。例如,动态资源限流处理器可根据系统负载动态收缩阈值,在高负载时快速降低流量压力,避免级联故障。

3. 动态调整与可观测性设计完善

• 动态阈值支持:通过配置中心(如Apollo、Nacos)监听阈值变更事件,调用处理器的updateXXXThreshold方法实时调整限流策略,适应业务流量的潮汐变化(如大促期间流量激增)。

• 监控指标上报:每个处理器统计限流次数、请求通过率等指标并上报至Prometheus/Grafana,为容量规划和故障排查提供了数据支撑。

4. 性能优化考虑全面

• 无锁统计:使用ConcurrentHashMap存储业务线计数器,SlidingWindowCounter采用原子操作(如AtomicLongArray)实现滑动窗口,避免了传统锁(如synchronized)的性能瓶颈。

• 轻量级判断顺序:处理器链优先执行低成本检查(如全局QPS),再执行高成本检查(如动态资源计算),减少无效计算。

• 异步处理支持:建议将请求计数操作异步化(如通过Disruptor环形缓冲区),降低对主线程的影响,确保低延迟。

二、潜在不足

1. 责任链长度与调用延迟

责任链模式通过链式调用逐层处理请求,若处理器数量过多(如后续扩展10+个处理器),可能导致调用延迟累积。例如,每个处理器的handle方法需依次执行,高并发场景下可能成为性能瓶颈(尽管单个处理器的时间复杂度为O(1),但链式调用的上下文切换仍需成本)。

2. 动态资源的准确性与延迟风险

动态资源限流处理器依赖系统监控客户端(如获取CPU、内存指标),若监控数据存在延迟(如采集周期为1秒)或不准确(如短暂峰值未捕获),可能导致限流阈值调整滞后。例如,CPU使用率瞬间飙升至90%,但监控客户端未及时上报,限流处理器仍按旧阈值放行请求,可能引发系统过载。

3. 配置动态化的可靠性挑战

方案提到通过配置中心动态调整阈值,但未详细说明并发更新时的线程安全问题。例如,当多个线程同时调用updateGlobalThreshold修改全局阈值时,若未做原子性校验(如CAS操作),可能导致阈值被错误覆盖,影响限流准确性。

4. 限流结果与降级层的联动不明确

方案提到“当限流触发时,返回降级响应”,但未明确限流结果如何传递至降级层。例如,限流层返回RateLimitResult.block()后,请求是直接被拦截(返回429),还是流转至降级层执行备用逻辑?若需触发降级,需定义清晰的接口规范(如降级层提供fallback方法),否则可能导致限流与降级逻辑脱节。

5. 滑动窗口实现的复杂度与内存占用

SlidingWindowCounter需维护多个时间窗口的计数器(如示例中“窗口大小1s,分100个桶”),若业务线数量较多(如1000+),每个业务线维护独立的滑动窗口,可能导致内存占用激增。此外,窗口划分过细(如100个桶)会增加计算当前QPS的复杂度(需累加所有桶的计数),高并发下可能影响性能。

6. 调试与问题排查难度

责任链的链式调用特性可能导致调试时难以快速定位问题(如某个处理器误判限流)。若缺乏日志追踪(如未记录每个处理器的决策过程)或链路追踪(如未关联requestId),故障排查效率会显著下降。

三、改进方向

1. 优化责任链性能:引入“短路”机制与并行处理

• 短路判断:在处理器链中增加“快速失败”条件(如全局QPS已超限),后续处理器无需执行,减少不必要的计算。

• 并行处理:对低依赖、无状态的处理器(如全局QPS限流),可通过线程池异步执行,降低主线程阻塞时间(需权衡异步带来的延迟)。

2. 提升动态资源的准确性

• 缩短监控采集周期:将系统监控客户端的数据采集周期从1秒缩短至100ms,或使用实时指标采集工具(如Micrometer + Prometheus Pushgateway)。

• 增加预阈值机制:在动态阈值调整前,设置缓冲区间(如CPU>70%时预触发限流),避免因监控延迟导致的决策滞后。

3. 强化配置动态化的线程安全

• 使用原子类(如AtomicInteger)存储阈值,确保updateXXXThreshold方法的原子性。

• 对配置变更事件增加版本号校验,避免旧版本配置覆盖新版本(如通过时间戳或递增版本号)。

4. 明确限流与降级的联动规则

• 在RateLimitResult中增加fallbackAction字段,定义降级层需执行的操作(如返回缓存、调用备用服务)。

• 限流层与降级层通过接口解耦(如定义DegradationService接口),限流触发时调用DegradationService.executeFallback(context)执行降级逻辑。

5. 优化滑动窗口的内存与计算效率

• 动态分桶:根据业务线的流量特征动态调整窗口分桶数(如高流量业务线分100桶,低流量分10桶),平衡内存与计算开销。

• 时间窗口压缩:使用环形缓冲区存储分桶计数,避免频繁创建/销毁对象,降低GC压力。

6. 增强可观测性与调试支持

• 全链路日志追踪:在RateLimitContext中记录requestId,并在每个处理器的handle方法中打印日志(如“全局限流处理器:当前QPS=8000,阈值=10000,允许通过”)。

• 链路追踪集成:与OpenTelemetry等工具对接,将限流决策过程关联到请求链路中,便于在APM平台(如SkyWalking)中可视化分析。

总结

该方案通过责任链模式实现了多维度、可扩展的限流能力,核心优势在于模式适配性、多场景覆盖、动态调整与性能优化,能够有效保障系统在高负载下的稳定性。

潜在不足主要集中在责任链性能、动态资源准确性、配置动态化可靠性等方面,可通过引入短路机制、优化监控采集、强化线程安全等措施改进。

总体而言,该方案是实用性较强的限流层设计方案,适用于大多数中大型分布式系统。

转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。可以在下面评论区评论,也可以邮件至 1056615746@qq.com